Sinds de lancering eind vorig jaar van ChatGPT, de op generatieve AI-gebaseerde chatbot van OpenAI, worden we overspoeld met wat ChatGPT allemaal kan. Zeker vanaf afgelopen maand toen GPT-4, de nieuwste versie van het taalmodel achter ChatGPT, werd gelanceerd. Maar hoe werkt ChatGPT nu echt? Welke data worden er gebruikt voor het trainen van GPT-4? Wat is de architectuur van GPT-4? En hoe worden GPT-4 en ChatGPT nu precies getraind?

Op basis van vele reacties op Twitter en het lezen van publicaties, luisteren van podcasts en het bekijken van online presentaties, zal ik de komende periode werken aan een blog over hoe ChatGPT nu echt werkt. Vandaag alvast een paar basisbegrippen en een overzicht van de bronnen die ik tot nog toe aangereikt heb gekregen.

Generatieve AI

Generatieve AI verwijst naar een tak van Artificiële Intelligentie (AI) die zich richt op het creëren van tekst, afbeeldingen, muziek of video, door het leren van bestaande gegevens. Deze vorm van AI gebruikt algoritmen en neurale netwerken om patronen, relaties en structuren in de gegevens te begrijpen en deze kennis te gebruiken om nieuwe, unieke creaties te genereren.

Momenteel onderscheiden we drie generatieve modellen: Generatieve Adversarial Networks (GAN’s), Variational Auto Encoders (VAE’s) en Transformer-gebaseerde modellen zoals OpenAI’s GPT-series.

GAN’s bestaan uit twee neurale netwerken, een generator en een discriminator, die tegen elkaar strijden in een soort spel. De generator probeert realistische gegevens te produceren, terwijl de discriminator probeert te bepalen of de gegenereerde gegevens echt of nep zijn. Door dit proces verbeteren beide netwerken zich voortdurend, wat uiteindelijk leidt tot de creatie van realistische en overtuigende nieuwe gegevens.

Ook VAE’s bestaan uit twee neurale netwerken, een encoder die gegevens comprimeert in latente variabelen en een decoder die deze variabelen gebruikt om nieuwe gegevens te genereren of oorspronkelijke gegevens te reconstrueren.

Transformer-gebaseerde modellen zijn neurale netwerken die tekst ‘begrijpen’ door context en betekenis te leren uit relaties in opeenvolgende woorden, zelfs als de woorden ver uit elkaar liggen. Ze vormen de basis voor GPT-4 en ChatGPT waar ik in deze blog nader op zal ingaan.

GPT

GPT staat voor Generative Pre-trained Transformer en is een Large Language Model (LLM), een foundation model ontwikkeld door OpenAI (inmiddels grotendeels in handen van Microsoft). Het is gebaseerd op de Transformer-architectuur die speciaal is ontworpen voor natuurlijke taalverwerking (NLP) taken zoals machinevertaling en tekstgeneratie. Het zijn met name deze modellen die vanaf 2017 een enorme verbetering in de resultaten van generatieve AI hebben laten zien (Vaswani, 2017).

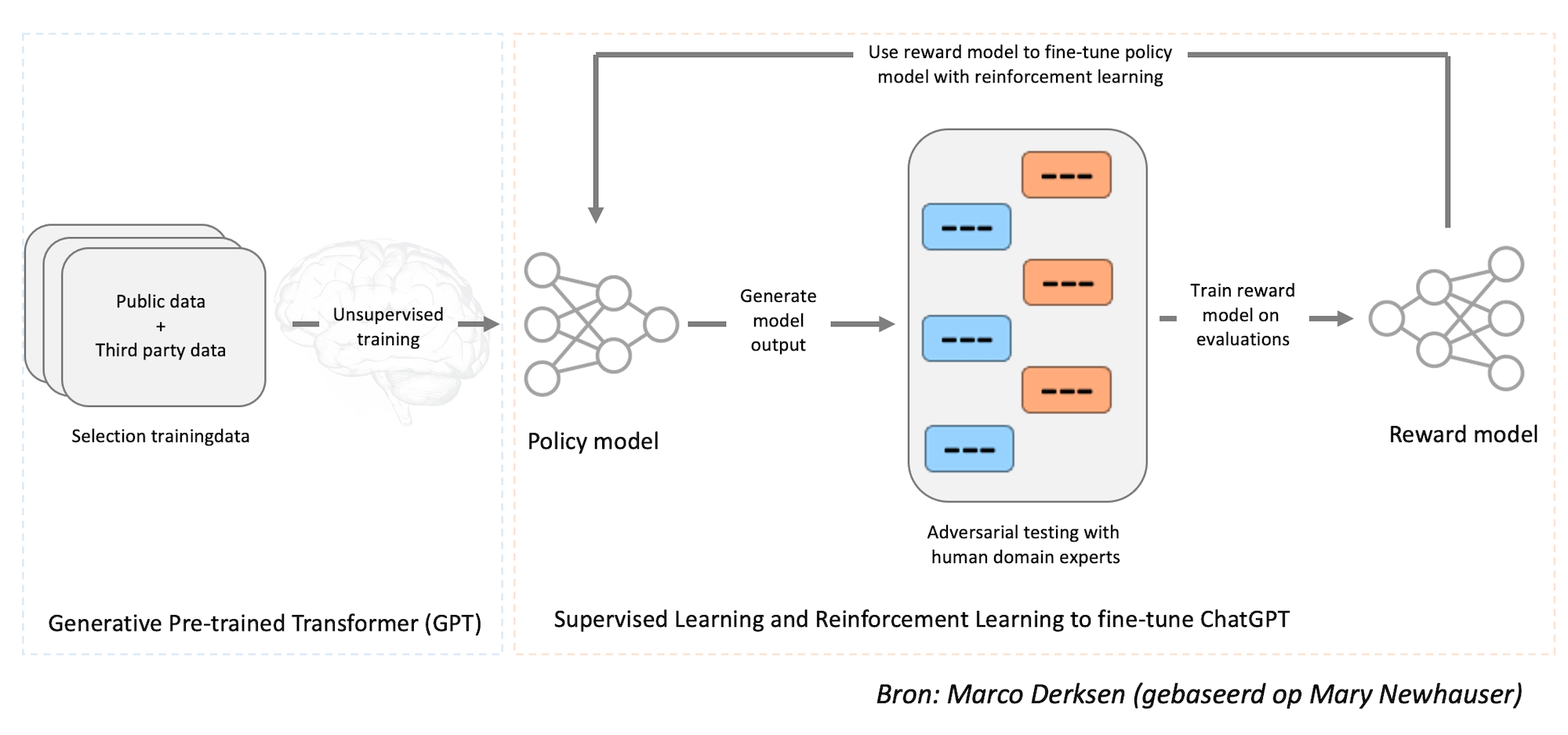

GPT is ontwikkeld door een unsupervised learning methode waarbij het model getraind wordt op grote hoeveelheden tekstdata (bijv. boeken, nieuwsartikelen, webpagina’s). Tijdens de training leert het model om de statistische verbanden tussen woorden en zinnen te begrijpen, zelfs als ze ver uit elkaar liggen, zodat het betekenisvolle tekst kan genereren.

GPT is één van de meest geavanceerde taalmodellen dat momenteel beschikbaar is en heeft vele toepassingen in de NLP-wereld, waaronder chatbots, samenvattingen, automatische vertalingen, enzovoort. Naast GPT kennen we andere modellen zoals Alexa TM (Amazon), BERT (Google) en LLAMA (Meta).

ChatGPT

ChatGPT is een toepassing van het GPT-model dat specifiek is ontworpen voor het voeren van gesprekken, terwijl GPT zelf een breder toepassingsgebied heeft in de NLP-wereld. GPT-4, de laatste versie van OpenAI’s GPT, is inmiddels geïntegreerd in online diensten als Microsoft Bing, Github Copilot, Duolingo, Be My Eyes en Khan Academy.

Voor ChatGPT wordt het foundation model middels een combinatie van supervised learning en reinforcement learning verder verfijnd, maar het is vooral de reinforcement learning-component die ChatGPT uniek maakt. De makers gebruiken een specifieke techniek genaamd Reinforcement Learning from Human Feedback (RLHF) die menselijke feedback gebruikt in de trainingslus om schadelijke, onwaarschijnlijke en/of bevooroordeelde output te minimaliseren.

Een eerste poging om een schematische weergave te maken van hoe GPT-4/ChatGPT werkt:

De komende tijd duik ik in de verschillende aspecten van ChatGPT, van data tot architectuur en training. Feedback en suggesties zijn meer dan welkom!

To be continued…

Bronnen:

- Attention Is All You Need (Vaswani et al., 2017)

- The Illustrated Transformer (Jay Allamer, 27 juni 2018)

- Language Models are Few-Shot Learners (Tom B. Brown et al., 2020)

- The Hitchhiker’s Guide to GPT3 (Giani Statie, 16 februari 2022)

- On the Opportunities and Risks of Foundation Models (Bommasani et al., 12 juli 2022)

- How ChatGPT actually works (Marco Ramponi, 23 december 2022)

- How ChatGPT is Trained (Ari Seff, 25 januari 2023)

- What Is ChatGPT Doing … and Why Does It Work? (Stephen Wolfram, 14 februari 2023)

- GPT-4 (Technical Report) (OpenAI, 15 maart 2023)

- GPT-4: Everything you want to know about OpenAI’s new AI model (E2Analyst, 15 maart 2023)

- Wie is eigenaar van OpenAI? (FourweekMBA, 23 maart 2023)

- Introductie video’s Amazon (Werner Vogels, 13 april 2023)

Mijn eerdere blogs over generatieve AI:

9 reacties

Over de RLHF is dit nog wel interessante materie… rechtstreeks uit het playbook van Bigtech: https://time.com/6247678/openai-chatgpt-kenya-workers/

Yep, die heb ik al in mijn lijst staan; maar zoek nog een bevestiging. En 2 dollar/uur is volgens mij voor Kenya best een flink salaris. Kortom, het voelde allemaal nog wat suggestief dat artikel. Wat vond jij?

Zie ook mijn eerdere reactie op LinkedIn.

Als Forbes, Time en Guardian er over berichten zit er wel een kern van waarheid. En zoals gezegd, het is niets nieuws voor BigTech om lage-lonen landen in te zetten voor dit werk. Ik vraag me af voor welk salaris jij dit werk zou doen? is er een salaris hoog genoeg? 😉

Moet er nog eens goed induiken. Als het idd gaat om het beoordelen van schokkende beelden, dan is geen enkel salaris hoog genoeg om daar continue mee te worden geconfronteerd. Maar ik heb eerlijk gezegd nog geen idee waar het nu precies over gaat.

Op LinkedIn inmiddels veel likes, maar nog weinig suggesties voor verdieping:

https://www.linkedin.com/feed/update/urn:li:activity:7053362603527393280/

Dank—mooie uitleg!

Andrej Karpathy: State of GPT

De Nederlandse bronnen die chatbots trainen staan bol van auteursrecht-schendingen, privé-gegevens en nepnieuws volgens de Groene Amsterdammer:

https://www.groene.nl/artikel/dat-zijn-toch-gewoon-al-onze-artikelen

Zie ook EenVandaag met Eva Hofman en Jarno Duursma:

https://eenvandaag.avrotros.nl/item/waar-haalt-chatgpt-zn-informatie-vandaan-zo-gevaarlijk-zijn-de-bronnen-van-ai/