De Rotterdamse politie hoopt door middel van een deepfake-video waarin het dertienjarige slachtoffer direct tot de dader en getuigen spreekt een moordzaak van twintig jaar geleden op te lossen. Voor zover bekend is het wereldwijd een primeur dat de politie een deepfake van een slachtoffer inzet. “We zijn ervan overtuigd dat het harten kan raken in het criminele milieu. Dat getuigen en misschien de dader zich kunnen gaan melden”, aldus een woordvoerder van de politie. Het gebruik van deepfakes roept tegelijkertijd ethische vragen op.

Op zondag 22 mei werd de documentaire Spreek! Nu! van WNL uitgezonden op NPO1. In de documentaire volgt de camera het Rotterdamse coldcase-team dat zich richt op de moord op de 13-jarige Sedar Soares. Een geruchtmakende zaak die door de jaren heen veel indruk maakte. Op basis van deepfake technologie wordt de vermoorde Sedar Soares tot ‘leven’ geroepen in een video om eventuele getuigen op te roepen. Onthullend en ontroerend. Met medewerking van het rechercheteam, de familie en vrienden van het slachtoffer en nooit eerder vertoond beeldmateriaal.

Op dezelfde avond van de uitzending zet de politie het bericht ‘Sedar (13) zoekt ‘zelf’ zijn moordenaar‘ online. In het bericht de deepfake video op YouTube, meer informatie over de zaak en de vraag aan de lezer om de oproep te delen.

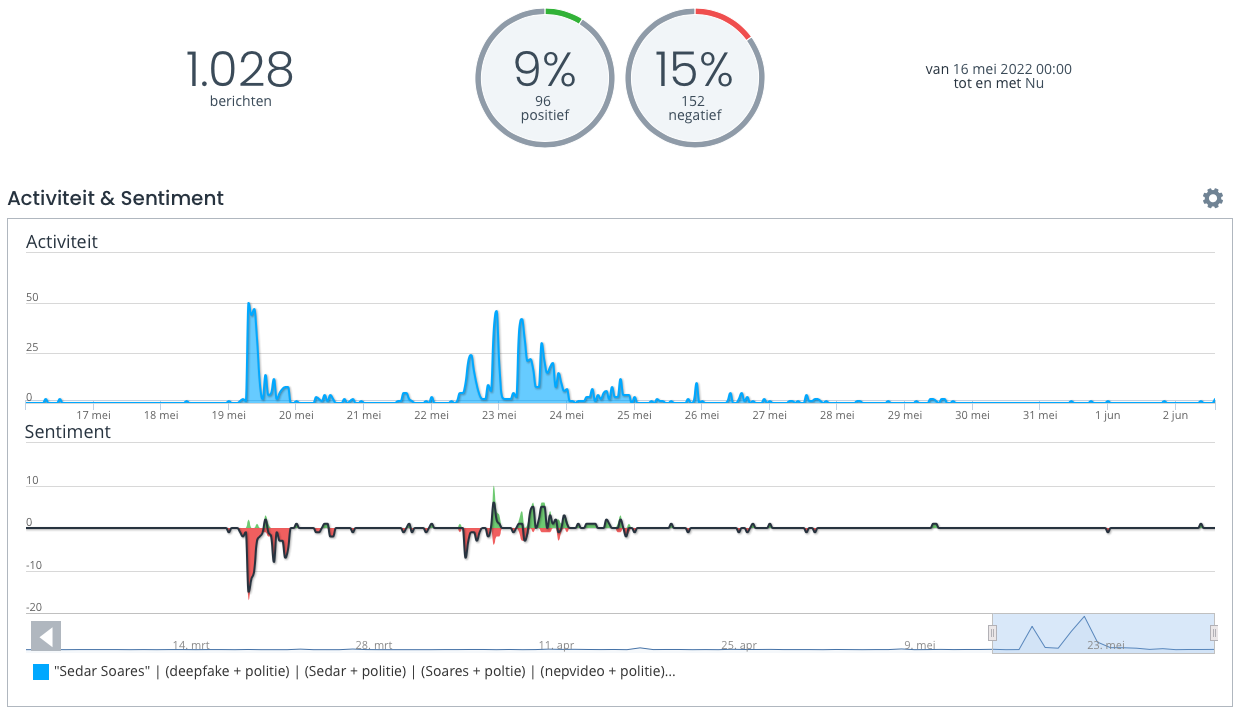

Het gebruik van deepfakes roept tegelijkertijd ethische vragen op. Met behulp van de mediamonitoringtool van Coosto vind ik honderden berichten over de case met daarin vooral verwijzingen naar het politiebericht, berichten op NOS.nl, Trouw, Volkskrant en een al wat ouder bericht op Rijnmond.nl.

De dag na de lancering van de deepfake video bespreken rechtbankverslaggever Saskia Belleman, ex-politiewoordvoerder Klaas Wilting en privacy- en big data-expert Bart van der Sloot de case in Op1. Het fragment in Op1 is online terug te kijken.

In de ochtend legt politiewoordvoerder Elianne Mastwijk (eenheid Rotterdam) bij Radio1 uit waarom voor deze vorm gekozen is. Techauteur en spreker Jarno Duursma vertelt kort hoe het werkt.

Die middag is Martin Sitalsing te gast bij Spraakmakers op NPO1 waarin hij uiteraard ook kort reageert op vragen over de inzet van deepfake technologie door de politie. Sitalsing vindt het in dit geval een goed idee om uit te proberen, maar vindt ook dat de politie hierna de ethische reflectie moet of je dit zou moeten willen als politie (vanaf 44:32 min).

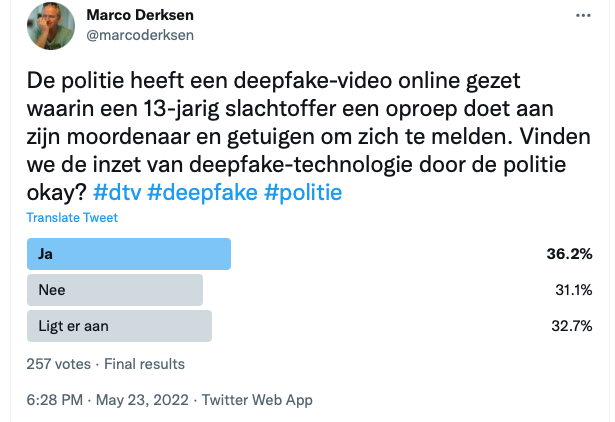

Zelf heb ik op LinkedIn en Twitter een kort bericht geplaatst over de case met daarin uiteraard ook de vraag wat mijn volgers daarvan vinden. Op Twitter leverde een niet-respresentatieve poll onder mijn volgers het volgende beeld:

Het is duidelijk dat de publieke opinie verdeeld is. Ongeveer 31 procent van de stemmers vindt het niet okay dat de politie deepfake technologie inzet voor het oproepen van getuigen. Ruim 36 procent vindt het juist wel okay en bijna 33 procent vindt dat inzet afhankelijk is van de situatie.

Op LinkedIn deelt Laurens Vreekamp tenslotte zeven takeaways van de politiedeepfake. Deepfakes volgens Vreekamp:

- zijn in te zetten voor maatschappelijke doeleinden,

- hebben waarde,

- zijn een nieuwe kunstvorm,

- zijn een volgende stap in de media/tech-evolutie,

- zijn nog niet volwassen,

- bieden werkgelegenheid,

- zijn gebaat bij transparantie.

Mijn slotconclusie is dat een goede keuze was om het experiment te hebben gedaan, maar dat het nu wel het moment is om de inzet van deepfake technologie door de politie te evalueren en men heel goed moet nadenken of je dit als politie wel wil in de toekomst.

Aanvullend is het goed om ook eens terug te kijken naar de deepfake van Mark Rutte destijds. Rob Wijnberg van de Correspondent, de makers van de deepfake video, evalueerde de inzet van deepfake video door een journalistiek medium in het artikel ‘Is een deepfake geen nepnieuws? (en nog 9 vragen over onze nepvideo van Mark Rutte)‘.

In beide voorbeelden is het doel de inzet van deepfake for good. Er was wel een belangrijk verschil. In de deepfake video van de politie wordt nadrukkelijk aangegeven dat het om een nepvideo gaat, dat gebeurt niet in de deepfake video van de Correspondent.

Ben uiteraard benieuwd wat het uiteindelijke standpunt gaat worden van de politie. Binnenkort zullen we in ieder geval ook in het leerprogramma leiderschap bij digitale transformatie van de Politieacademie aandacht besteden aan deze case!

4 reacties

Interessant artikel Marco en ik denk dat het goed is om als maatschappij het gesprek te voeren over deepfakes,, maar dan niet als technologisch verschijnsel maar juist als maatschappelijk verschijnsel. Het is vooral van belang om te spreken over welke onderliggende waarden er op het spel staan. Voor degene die meer wetenschappelijke verdieping over dit onderwerp wil, verwijs ik naar bij master thesis die ik vorig jaar over ethiek en deepfakes heb geschreven. Deze is hier in open access te downloaden: https://extremebeliefs.com/book/deepfakes-and-extreme-beliefs/

Dank voor je reactie Jack en heb inmiddels je master thesis gedownload!

Door de opkomst van deepfakes zal de vraag ‘Wat is echt?’ steeds vaker op de politieke en maatschappelijke agenda komen te staan. Deepfakes kunnen worden gebruikt om nepnieuws te verspreiden, verkiezingen te beïnvloeden, realistisch fakebewijs aan rechters voor te leggen en fake pornofilms van vrouwen te maken. Ieder van deze toepassingen heeft potentieel een zeer grote impact op de samenleving, sociale structuren en de democratische rechtsorde. Dat blijkt uit een eerder verschenen onderzoek van het Tilburg Institute for Law, Technology, and Society (TILT) in opdracht van het WODC:

https://www.tilburguniversity.edu/nl/actueel/persberichten/deepfakes-kunnen-op-termijn-de-samenleving-ontwrichten

Nog enkele lezenswaardige publicaties over deepfakes:

How Easy Is It to Make and Detect a Deepfake?

https://insights.sei.cmu.edu/blog/how-easy-is-it-to-make-and-detect-a-deepfake/

Increasing Threat of Deepfake Identities:

Klik om toegang te krijgen tot increasing_threats_of_deepfake_identities_0.pdf

Tackling deepfakes in Europe:

Klik om toegang te krijgen tot EPRS_STU(2021)690039_EN.pdf

The State of Deepfakes 2019:

Klik om toegang te krijgen tot deepfake_report.pdf