Net als miljoenen anderen heb ik gisteren gekeken naar Google I/O 2025. De jaarlijkse ontwikkelaarsconferentie van Google in San Francisco stond opnieuw volledig in het teken van AI, met de nieuwe Gemini 2.5 als motor achter vrijwel alles. Voor velen was Google al afgeschreven in de race op het gebied van search en AI, maar het lijkt erop dat Google met Gemini een geduchte concurrent is van large language models als GPT, Grok, Claude en Llama.

Ik was onder de indruk van de nieuwe AI-modus in Search, Project Astra als slimme assistent, en de video- en beeldgeneratie via Veo 3 en Imagen 4. Ook de integratie van Gemini in Gmail, Chrome, Android en vergadertools zag er goed uit. Gemini is geen losse AI-tool, maar een AI-infrastructuur voor alles wat Google te bieden heeft. Wat mij vooral opviel, was de schaal en snelheid waarmee Google AI in zijn hele ecosysteem verwerkt. Tegelijkertijd vroeg ik me af wat dit betekent voor het energieverbruik. Wat kost AI aan energie?

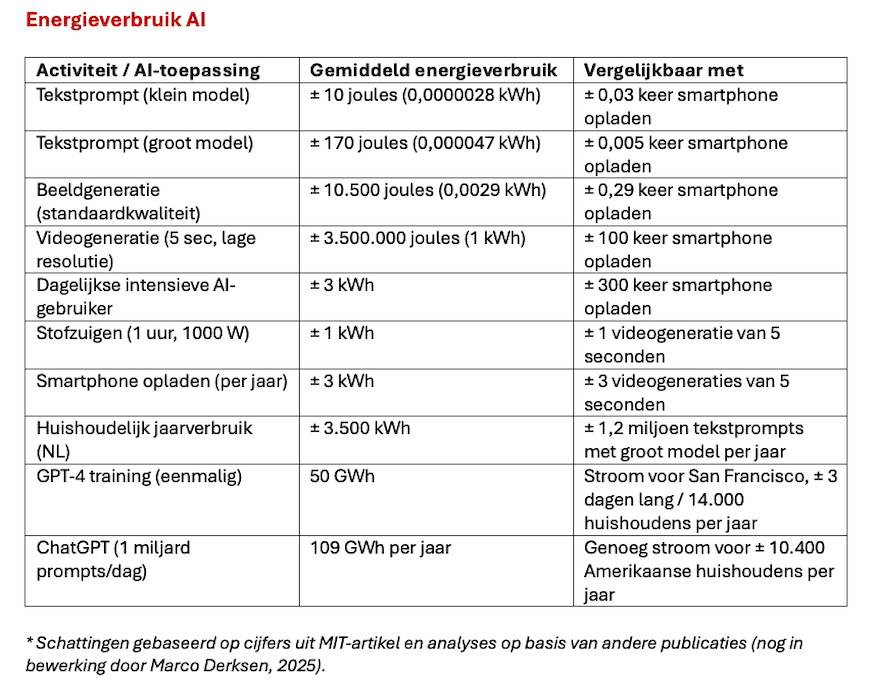

Afgelopen week las ik toevallig een artikel in MIT Technology Review over de vraag hoeveel stroom AI eigenlijk verbruikt. Voor geïnteresseerden een korte samenvatting.

Volgens de auteurs van het MIT-artikel ging de meeste publieke aandacht tot nu toe uit naar het trainingsproces van grote taalmodellen zoals GPT-4. Dat kostte naar schatting meer dan 100 miljoen dollar en verbruikte ongeveer 50 gigawattuur elektriciteit – vergelijkbaar met drie dagen stroomverbruik in San Francisco. Maar dat is een eenmalige investering. De werkelijke energieconsumptie zit in de zogeheten inference-fase: het moment waarop gebruikers dagelijks vragen stellen, teksten laten genereren of beelden laten maken. En die fase is niet alleen constant, maar groeit razendsnel mee met het aantal gebruikers en toepassingen.

Onderzoekers werkten samen met universiteiten en AI-experts om het energieverbruik van verschillende open-sourcemodellen te meten, zoals Meta’s Llama en de beeldgenerator Stable Diffusion. De variatie per actie bleek groot. Een klein taalmodel verbruikt voor een antwoord gemiddeld 114 joule; bij een groot model kan dat oplopen tot meer dan 6.700 joule. Voor het genereren van een afbeelding is gemiddeld 2.300 tot 4.400 joule nodig. Videogeneratie is het meest intensief: een HD-video van vijf seconden vraagt ongeveer 3,4 miljoen joule – evenveel als een uur lang een magnetron laten draaien of 60 kilometer rijden op een e-bike.

Voor een gemiddelde dagelijkse gebruiker – iemand die vijftien vragen stelt, tien beelden genereert en drie korte video’s maakt – komt het totale energieverbruik uit op ongeveer 2,9 kilowattuur. Dat staat gelijk aan 3,5 uur magnetrongebruik, 100 kilometer fietsen op een e-bike of 10 kilometer rijden met een elektrische auto. En dat is per persoon, per dag.

Wanneer je deze cijfers extrapoleert naar mondiale schaal, wordt het pas echt zichtbaar. ChatGPT verwerkt inmiddels ongeveer een miljard berichten per dag, en er worden dagelijks meer dan 78 miljoen beelden gegenereerd. Alleen al het beantwoorden van tekstvragen zou op jaarbasis meer dan 100 gigawattuur vergen. Tel je de beelden en video’s erbij op, dan stijgt dat getal snel.

Ook op nationaal niveau zijn de gevolgen aanzienlijk. In de Verenigde Staten verbruikten datacenters in 2024 naar schatting 200 terawattuur elektriciteit. Van dat totaal wordt tussen de 53 en 76 terawattuur toegeschreven aan AI-systemen – genoeg om meer dan zeven miljoen huishoudens een jaar lang van stroom te voorzien. Als de groei van AI-gebruik aanhoudt, zou dit in 2028 kunnen oplopen tot 165 tot 326 terawattuur per jaar – het equivalent van 22 procent van alle Amerikaanse huishoudens.

Een belangrijk probleem is de herkomst van die elektriciteit. Veel datacenters draaien op netwerken met een relatief hoge CO₂-uitstoot, zoals in Virginia en Pennsylvania. Volgens Harvard is de stroom die datacenters gebruiken gemiddeld 48 procent vervuilender dan het nationale gemiddelde. Omdat deze centra dag en nacht draaien, is het lastig om volledig op duurzame energie over te schakelen. Kernenergie wordt soms genoemd als oplossing, en techbedrijven als Google, Meta en Amazon investeren in nieuwe nucleaire projecten. Maar het bouwen van die infrastructuur kost jaren, terwijl de vraag nu al piekt.

Daarbij komt een gebrek aan transparantie. Grote technologiebedrijven geven nauwelijks inzicht in het energieverbruik van hun AI-modellen. Onderzoekers zijn daarom aangewezen op indirecte schattingen en simulaties met open modellen. Intussen sluiten techbedrijven deals met regionale energiebedrijven, waarbij burgers mogelijk meebetalen aan de uitbreiding van het netwerk. In de Amerikaanse staat Virginia zou dit volgens berekeningen kunnen leiden tot 37,50 dollar extra per maand op de stroomrekening van huishoudens.

De belangrijkste conclusie uit het MIT-onderzoek is dat het tijd is om verder te kijken dan de innovatie zelf. De dagelijkse werking van AI is allesbehalve immaterieel. Achter iedere slimme assistent, elk gegenereerd beeld of chatbotantwoord gaat een keten van servers, stroom en infrastructuur schuil. De maatschappelijke discussie over AI mag zich niet beperken tot wat er technisch mogelijk is, maar moet ook gaan over wat duurzaam, transparant en eerlijk is. Want hoe slimmer de systemen, hoe groter de vraag die ze stellen aan ons elektriciteitsnet en de energie footprint!

9 reacties

In het artikel AI in the Era of Climate Change: Solution or Problem? onderzoekt wetenschapsjournalist Bennie Mols de rol van kunstmatige intelligentie (AI) in de klimaatcrisis. Aanleiding is een sessie tijdens de jaarlijkse bijeenkomst van de American Association for the Advancement of Science (AAAS), waar wetenschappers bespraken of AI een klimaatoplossing of -versneller is.

AI blijkt aan twee kanten van de klimaatbalans te staan. Volgens Priya Donti (MIT) kan AI positieve impact hebben door betere analyses van broeikasgasemissies, slimmere voorspellingen van hernieuwbare energie, en optimalisatie van energiesystemen en vervoer. Ze wijst op praktische toepassingen zoals Deutsche Bahn, dat AI inzet voor vroegtijdige detectie van storingen in het spoor. Ook wetenschappelijk onderzoek profiteert, bijvoorbeeld bij het ontwikkelen van nieuwe batterijen of efficiëntere materialen.

Tegelijkertijd groeit het energieverbruik van AI, vooral door de opmars van grote taalmodellen. Eric Masanet (UC Santa Barbara) voorspelt dat het aandeel van AI-datacenters in het totale Amerikaanse stroomverbruik stijgt van 4,4% in 2024 tot mogelijk 12% in 2028. Deze toename wordt bemoeilijkt door gebrek aan transparante data over servers, koeltechnologie en gebruikte energiebronnen. Masanet benadrukt bovendien dat het milieueffect verder gaat dan alleen elektriciteit: ook waterverbruik en materiaalgebruik zijn relevant.

Naast infrastructuur richt Elke Weber (Princeton) zich op gedrag. Veel mensen weten volgens haar niet welke acties echt bijdragen aan klimaatverandering. AI kan helpen door tijdige suggesties te geven, bijvoorbeeld via slimme apparaten of apps, en zo individueel en collectief gedrag te beïnvloeden. Tegelijk waarschuwt ze voor de risico’s van generatieve AI, zoals het verspreiden van misinformatie of verlamming door tegenstrijdige berichten.

De conclusie van het artikel is dat AI geen neutrale technologie is. De impact op het klimaat hangt sterk af van hoe en waar AI wordt ingezet. Mols laat zien dat technologische efficiëntie alleen niet voldoende is. Zonder scherp beleid, transparantie en systeemreflectie bestaat het risico dat AI bestaande problemen versterkt. De aanbeveling is dan ook om AI expliciet onderdeel te maken van klimaatbeleid, en andersom. Alleen met bewuste keuzes en maatschappelijke sturing kan AI bijdragen aan een duurzame toekomst.

Voormalig Google-CEO Eric Schmidt waarschuwde afgelopen maand in een toespraak voor het Amerikaanse Congres dat superintelligente AI een ongekende druk op het wereldwijde energiesysteem zal leggen. Hij schetst een toekomst waarin AI-datacenters tot wel 99% van de wereldwijde elektriciteitsproductie zouden kunnen verbruiken. Volgens Schmidt wordt er al gewerkt aan datacenters van 10 gigawatt, terwijl een gemiddelde kerncentrale slechts 1 gigawatt levert. De voorspelling is dat datacenters in 2027 29 gigawatt extra stroom nodig hebben, oplopend tot 67 gigawatt in 2030. De huidige energiestructuur en regelgeving zijn daar niet op voorbereid. Vergunningstrajecten voor nieuwe energie-infrastructuur duren gemiddeld 18 jaar. Schmidt pleit daarom voor federale maatregelen om deze processen te versnellen, inclusief investeringen in alle vormen van energie, zowel fossiel als hernieuwbaar, omdat fusie-energie nog te laat komt om aan de groeiende vraag te voldoen. Zijn boodschap: als de VS leiderschap wil behouden in AI, moet het eerst de energiecrisis oplossen die deze technologie veroorzaakt.

Zie ook het artikel We Need Energy for AI, and AI for Energy:

As the march of AI accelerates, a new requirement has become apparent: the next breakthroughs will consume colossal quantities of energy. AI guzzles electricity: a single ChatGPT query requires ten times as much as a conventional web search. As AI usage increases, its energy requirements will rise, and if demand outstrips supply, the technology’s development will be strangled.

The data centers that underpin AI development at scale – powering GPT-4, Gemini, and other frontier models – need around-the-clock access to power. They already account for roughly 3% of annual US electricity consumption, and this share is expected to more than double in the next five to ten years. More broadly, AI’s electricity usage is projected to increase from four terawatt-hours in 2023 to 93 TWh in 2030 – more than Washington State used in 2022. And that’s a conservative estimate; AI could consume this much power as early as 2025.

Het artikel Generative AI: energy consumption soars (Polytechnique Insights, 2024) onderzoekt de stijgende energiebehoefte van generatieve AI in het licht van mondiale zorgen over klimaatverandering en duurzaamheid. Aanleiding is de snelle adoptie van AI-modellen die grote hoeveelheden rekenkracht en dus elektriciteit vergen.

Generatieve AI zoals ChatGPT vraagt fors meer energie dan klassieke digitale toepassingen. Volgens de IEA kan het wereldwijde stroomverbruik van datacenters, AI en cryptovaluta tussen 2022 en 2026 met 160 tot 590 TWh toenemen—vergelijkbaar met het verbruik van Zweden tot Duitsland. Eén AI-interactie kost tot tien keer meer stroom dan een gewone Google-zoekopdracht.

Exacte cijfers ontbreken. Google meldt dat machine learning minder dan 15% van hun verbruik uitmaakt, maar deelt geen details. Onderzoeker Alex de Vries schat het AI-verbruik in 2023 op 5,7–8,9 TWh, met mogelijk 134 TWh in 2027. Ook de gebruiksfase (inference) weegt inmiddels zwaarder dan de trainingsfase. Gebruik door eindgebruikers blijkt verantwoordelijk voor 25–45% van de CO₂-uitstoot.

Optimalisatie helpt amper door het rebound-effect: efficiëntere AI leidt tot méér gebruik. Volgens Ligozat is matiging de enige serieuze optie. Zonder regie en transparantie blijft AI’s energievoetafdruk ongecontroleerd groeien.

De opkomst van kunstmatige intelligentie en verdere digitalisering zet het Nederlandse elektriciteitsnet onder druk. Volgens een recente toekomstverkenning van Netbeheer Nederland kan het stroomverbruik van datacenters in 2050 oplopen tot 40 tot 70 procent van de huidige totale elektriciteitsvraag van Nederland. Deze ontwikkeling roept vragen op over de capaciteit van het stroomnet en de inrichting van het toekomstige energiesysteem.

De aanleiding voor de discussie is het rapport van Netbeheer Nederland, waarin vier scenario’s worden geschetst voor een klimaatneutraal Nederland in 2050. Daarin krijgt de groeiende elektriciteitsvraag van datacenters veel aandacht. De verkenning is gebaseerd op klantaanvragen en trends en laat zien dat de vraag naar rekenkracht toeneemt door digitale toepassingen, vooral AI. “Dat past niet,” zegt Manon van Beek, directeur van hoogspanningsbeheerder Tennet, verwijzend naar de beperkingen van het huidige stroomnet. Volgens haar is flexibiliteit van datacenters cruciaal: ze moeten hun verbruik kunnen aanpassen aan het fluctuerende aanbod van wind- en zonne-energie. Als dat niet gebeurt, wordt het lastig om deze groei in te passen.

Van Beek wijst ook op een ander effect: de groeiende stroomvraag van datacenters kan juist ook positief zijn voor de energietransitie. Omdat de elektrificatie in de industrie achterblijft, stagneert bijvoorbeeld de bouw van windparken. Extra vraag vanuit datacenters kan de duurzame opwekking van stroom economisch aantrekkelijker maken. Of dat wenselijk is, laat ze in het midden: “Dat is een vraag die de politiek moet beantwoorden.”

De Dutch Data Center Association (DDA) reageert kritisch op de cijfers in het rapport. Zij noemt de voorspellingen “zwaar overdreven” en wijst op de huidige beperkingen: “We gebruiken nu 4 tot 5 procent van alle stroom en kunnen niet eens uitbreiden vanwege netcongestie.” Volgens de DDA zijn eerdere voorspellingen over een explosieve groei niet uitgekomen. Ze benadrukken dat AI-systemen en datacenterapparatuur steeds efficiënter worden. Daarnaast stelt de DDA dat datacenters juist kunnen bijdragen aan flexibiliteit, bijvoorbeeld door grote accu’s of door zich te vestigen bij windparken aan de kust.

De discussie legt een fundamentele spanning bloot tussen digitale ambities en fysieke grenzen. De groei van datacenters wordt vaak voorgesteld als een autonoom proces dat gefaciliteerd moet worden. Tegelijkertijd laat de analyse zien dat keuzes over waar en hoe datacenters groeien, diep verweven zijn met strategische vragen over energiebeleid, infrastructuur en maatschappelijke prioriteiten.

De belangrijkste aanbeveling uit deze discussie is dat er helder beleid nodig is over de rol van datacenters in het toekomstige energiesysteem. Niet alleen technisch, maar ook maatschappelijk. Moet Nederland alle digitale groei faciliteren, of is er ook ruimte om te sturen op type gebruik, maatschappelijke waarde en ruimtelijke inpassing? Dat vraagt om een gezamenlijke strategie van overheid, netbeheerders en de digitale sector, gericht op wederzijdse afstemming in plaats van parallelle werkelijkheden.

Reactie van Christine op Bluesky: “Ik denk dat we als de wiedeweerga in Europa moeten investeren in de bouw van neurale chips. Geen biochips, maar chips met in silicium geemuleerde neurale netwerken die duizend keer minder stroom gebruiken dan gewone chips. Dat kan, maar niemand lijkt het te willen.”

Heb het hier eerder met Christine over gehad. Ben inmiddels een blog aan het schrijven over neuromorfe chips, chips geïnspireerd op de werking van het menselijk brein die volgens publicaties veelbelovend zijn. Een concreet voorbeeld is de Loihi 2-chip van Intel, die met ongeveer één miljoen kunstmatige neuronen complexe taken uitvoert met een fractie van het energieverbruik van traditionele hardware. Ook het Europese project BrainScaleS 2 laat zien dat het mogelijk is om real-time leeralgoritmen uit te voeren met een zeer laag stroomverbruik.

Gisteren bij Nieuwsuur:

https://nos.nl/nieuwsuur/artikel/2568297-nieuw-onderzoek-ai-verbruikt-11-tot-20-procent-van-wereldwijde-stroom-datacenters

Zie ook (vanaf 34:40):

https://npo.nl/start/serie/nieuwsuur/seizoen-2025/nieuwsuur_5088/afspelen

Maar ook in The Guardian en andere media:

https://www.theguardian.com/environment/2025/may/22/ai-data-centre-power-consumption

AI was in 2024 verantwoordelijk voor 11 tot 20 procent van het wereldwijde stroomverbruik van datacenters, blijkt uit onderzoek van de Vrije Universiteit Amsterdam. Vanwege het gebrek aan transparantie bij bedrijven als OpenAI en Meta, gebruikte onderzoeker Alex de Vries-Gao een indirecte methode: hij berekende op basis van chipproductie bij TSMC hoeveel AI-systemen wereldwijd draaien en wat die verbruiken.

Het Internationaal Energieagentschap (IEA) verwacht dat het wereldwijde stroomverbruik van datacenters stijgt van 415 terawattuur in 2024 naar 945 terawattuur in 2030 – vergelijkbaar met het huidige verbruik van Japan. AI is de belangrijkste aanjager. In Nederland voorspelt Netbeheer Nederland een stijging van 40 tot 70 procent in 2050. Tegelijk zit het stroomnet op veel plekken vol.

Onderzoekers aan de TU Delft werken aan energiezuinigere AI-modellen en ontwikkelden een plug-in die toont hoeveel energie een ChatGPT-vraag kost. Veel gebruikers blijken het verbruik te onderschatten. Google en Microsoft wijzen op hun groene ambities, maar geven geen harde cijfers.

Conclusie: het stroomverbruik door AI groeit snel, terwijl inzicht en sturing ontbreken. Transparantie is cruciaal om keuzes te maken over wat we met energie willen doen in een digitale samenleving.

In Stijn Bronzwaer’s NRC-Broncode vandaag:

“Alex de Vries-Gao is dé expert op het gebied van stroomverbruik van crypto en kunstmatige intelligentie. Deze week kwam hij met een nieuw rapport: AI dreigt snel crypto in te halen als grote digitale stroomslurper.

Maar wacht even, bespaart AI niet ook veel energie? En worden datacentra niet steeds zuiniger? Misschien wel, al zijn daar de nodige kanttekeningen bij te plaatsen.

Stroomvreters. Het is altijd interessant om Alex de Vries-Gao te spreken. Datawetenschapper aan de VU, onderzoeker bij De Nederlandsche Bank en dé expert op gebied van stroomverbruik van digitale diensten. Crypto-investeerders omschreven hem op sociale media al eens als ‘volksvijand nummer 1’. Ik was vorig jaar een keer bij hem thuis in Almere (een zéér energiezuinige woning, maar dat terzijde).

Hij e-mailde me deze week dat hij nieuw onderzoek had gedaan naar het energieverbruik van AI. Dat het stroomverbruik van kunstmatige intelligentie enorm toeneemt is helder, maar onduidelijk is steeds met hoeveel precies. Techbedrijven weigeren daarover, tot frustratie van De Vries-Gao, openheid van zaken te geven.

De Vries-Gao sloeg aan het rekenen. Telefonisch vertelde hij me hoe. Door documenten van Chinese analisten die chipmaker TSMC volgen te vertalen, door eindeloos investor calls van chipbedrijven door te ploegen om maar te zien wie welke orders heeft gedaan. Monnikenwerk, maar iemand moet het doen.

Zijn belangrijkste conclusies (nb: dit zijn projecties, maar de beste die we hebben):

Wat moeten we hiermee? Het is ingewikkeld. Het berekenen van stroomverbruik van AI is notoir lastig, zeker als de bedrijven er zelf niet transparant over zijn.

En is al die aandacht voor stroomverbruik van AI niet een beetje overtrokken? Een föhn of een magnetron gebruiken kost nog altijd meer stroom dan een vraag aan een willekeurige chatbot. Daar staat dan weer tegenover dat een uur Netflixen minder stroom kost dan één vraag aan ChatGPT (oké oké, afhankelijk van de kwaliteit van de stream en het apparaat waar je op kijkt, maar toch).

En, de belangrijkste kritiek: bespaart AI (itt crypto) niet ook heel veel energie? De voorbeelden daarvan zijn eindeloos. Denk aan KLM dat 100.000 kilo voedsel per jaar bespaart, nu AI exact voorspelt per vlucht hoeveel maaltijden ze aan boord moeten hebben. Of telers in het Westland die AI inzetten om de temperatuur in de kas zo laag mogelijk te houden en om water te besparen. En worden datacentra niet ook steeds zuiniger?

Allemaal waar, zegt Alex de Vries-Gao. Al is hij sceptisch over de beloftes die worden gedaan: „dat moeten we allemaal nog maar zien”. En, weet hij ook: als het gebruik van een nieuwe technologie steeds zuiniger wordt, leidt dat ertoe dat die technologie ook méér wordt gebruikt. Deze paradox, in de economie de Paradox van Jevons genoemd, leidt er in de praktijk toe dat energiebesparing uiteindelijk weer teniet wordt gedaan, omdat de populariteit van de technologie groeit.

(Mini-economieles: De Paradox van Jevons werd bedacht door de Britse econoom William Stanley Jevons, die in 1865 concludeerde dat technische uitvindingen die het gebruik van kolen zuiniger maakten tot effect hadden dat mensen juist meer kolen gingen gebruiken. Dit effect zie je bij AI opnieuw, stelt De Vries-Gao)

Wat moeten we nu doen, vroeg ik hem. Heeft hij advies? Allereerst moeten techbedrijven transparant zijn over de stroom die AI verbruikt. En roept hij bedrijven op die, ook in Nederland, niet massaal op AI te springen als oplossing voor alles.”

Toenemende inzet van Generatieve AI door overheid vereist aandacht voor duurzaamheid

https://www.uu.nl/nieuws/toenemende-inzet-van-generatieve-ai-door-overheid-vereist-aandacht-voor-duurzaamheid

Generatieve AI is de laatste tijd sterk in opkomst en zal naar verwachting ook productieprocessen in de publieke sector gaan veranderen. Deze technologie kan verschillende informatieverwerkingstaken binnen overheidsorganisaties ondersteunen. Uit een Brits onderzoek blijkt dat meer dan 20% van de professionals in de publieke sector GenAI gebruikt. Critici wijzen echter op de stijgende (duurzaamheids)kosten, zoals energie- en waterverbruik. Deze kosten worden vaak over het hoofd gezien. Overheden die GenAI gebruiken, moeten manieren vinden om deze negatieve gevolgen te beperken, maar er zijn weinig richtlijnen voor het beheren van (duurzaamheids)kosten. Onderzoekers van de Universiteit Utrecht hebben in opdracht van het Ministerie van Binnenlandse zaken scenario’s ontwikkeld die inzicht geven in de verwachte kosten en mogelijke aanpassingstrategieën bedacht.